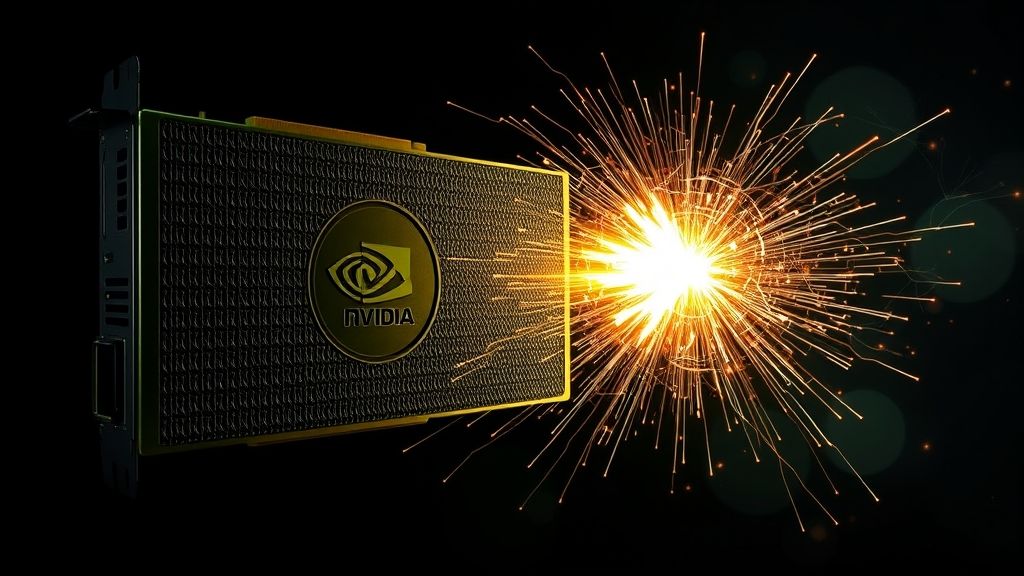

在当今快速发展的AI领域,开发者面临着日益增长的计算和内存需求。传统桌面级系统往往难以满足大型AI模型微调、高分辨率图像生成等密集型任务的要求,迫使工作流程迁移至云端或数据中心,增加了成本和等待时间。NVIDIA DGX Spark应运而生,作为一款紧凑型超级计算机,它为AI开发者提供了一个强大的本地化计算平台,有效解决云端实例和数据中心排队等待的问题。

DGX Spark的核心优势在于其强大的计算能力和充裕的内存。该系统集成了 Blackwell 架构GPU,提供高达1 Petaflop的FP4 AI计算性能,并配备128 GB的统一系统内存,内存带宽高达273 GB/秒。最重要的是,DGX Spark预装了完整的NVIDIA AI软件栈,开发者无需额外配置即可立即投入工作。

加速模型微调,突破内存瓶颈

模型微调是AI开发中的常见任务。DGX Spark在三种主流微调方法上展现出卓越性能:

- 全模型微调:在使用PyTorch进行Llama 3.2B模型的全模型微调时,DGX Spark实现了高达82,739.2 tokens/秒的峰值吞吐量。

- LoRA微调:在DGX Spark上,使用PyTorch进行Llama 3.1 8B模型的LoRA微调,峰值吞吐量可达53,657.6 tokens/秒。

- QLoRA微调:针对Llama 3.3 70B模型,采用QLoRA方法,DGX Spark实现了5,079.4 tokens/秒的峰值吞吐量。

值得注意的是,这些内存密集型的微调任务是32 GB消费级GPU无法胜任的。DGX Spark凭借其大容量内存,彻底解决了这一痛点。

| 模型 | 微调方法 | 后端 | 配置 | 峰值 Tokens/秒 |

|---|---|---|---|---|

| Llama 3.1 8B | 全模型微调 | PyTorch | – | 82,739.20 |

| Llama 3.1 8B | LoRA | PyTorch | – | 53,657.60 |

| Llama 3.3 70B | QLoRA | PyTorch | – | 5,079.04 |

(表1:模型微调性能)

释放图像生成潜能,提升图像质量与速度

图像生成模型对内存和计算能力的需求尤为突出,更高的分辨率和更快的生成速度是持续追求的目标。DGX Spark凭借其庞大的GPU内存和强大的计算性能,使得开发者能够处理更大分辨率的图像和更高精度的模型,从而生成更高质量的图像。

DGX Spark支持FP4数据格式,显著加快了图像生成速度。例如,在使用Flux.1 12B模型以FP4精度进行图像生成时,DGX Spark仅需2.6秒即可生成一张1K分辨率的图像。此外,其大容量系统内存还能运行BF16 SDXL 1.0模型,每分钟可生成七张1K分辨率的图像。

| 图像生成模型 | 精度 | 后端 | 配置 | 每分钟图像数 |

|---|---|---|---|---|

| Flux.1 12B | FP4 | TensorRT | – | 23 |

| SDXL 1.0 | BF16 | TensorRT | – | 7 |

(表2:图像生成性能)

赋能数据科学,加速数据分析与模型训练

对于UMAP和HDBSCAN等计算密集型的机器学习算法,DGX Spark能够以秒级速度处理250 MB的数据集。NVIDIA cuDF库更是极大地加速了常见的Pandas数据分析任务,如数据合并(joins)和字符串处理。在DGX Spark上,处理包含数千万条记录的数据集,关键的cuDF Pandas操作仅需数秒即可完成。

| 数据科学库 | 基准测试 | 数据集大小 | 时间 |

|---|---|---|---|

| NVIDIA cuML | UMAP | 250 MB | 4 秒 |

| NVIDIA cuML | HDBSCAN | 250 MB | 10 秒 |

| NVIDIA cuDF | Pandas关键操作 | 0.5 – 5 GB | 11 秒 |

(表3:数据科学性能)

提升推理效率,实现快速响应

DGX Spark的Blackwell GPU支持FP4数据格式,特别是NVFP4格式,其精度接近FP8,仅有不足1%的性能损失。这使得在不牺牲准确性的前提下,可以使用更小的模型,从而进一步提升性能。FP4格式更小的数据占用也带来了更快的处理速度。

DGX Spark支持多种4位数据格式,包括NVFP4和MXFP4,并兼容TRT-LLM、llama.cpp和vLLM等多种后端。系统提供的1 Petaflop AI性能,能够实现极快的提示处理(prompt processing),显著缩短首次响应Token的生成时间,从而为用户提供更佳体验并加速端到端吞吐量。

| 模型 | 精度 | 后端 | 提示处理吞吐量 (tokens/sec) | Token生成吞吐量 (tokens/sec) |

|---|---|---|---|---|

| Qwen3 14B | NVFP4 | TRT-LLM | 5928.95 | 22.71 |

| GPT-OSS-20B | MXFP4 | llama.cpp | 3670.42 | 82.74 |

| GPT-OSS-120B | MXFP4 | llama.cpp | 1725.47 | 55.37 |

| Llama 3.1 8B | NVFP4 | TRT-LLM | 10256.9 | 38.65 |

| Qwen2.5-VL-7B-Instruct | NVFP4 | TRT-LLM | 65831.77 | 41.71 |

| Qwen3 235B | NVFP4 | TRT-LLM | 23477.03 | 11.73 |

(表4:推理性能)

扩展应用场景:双DGX Spark系统协同工作

为了验证DGX Spark的强大扩展能力,研究人员将两台DGX Spark通过ConnectX-7网卡连接,成功运行了需要超过120GB内存(包含开销)的Qwen3 235B模型。通常这类模型需要部署在大型云端或数据中心服务器上。然而,此次试验表明,即使是用于开发者实验,双DGX Spark系统也足以应对如此复杂的模型。如表4最后一行的结果所示,双DGX Spark系统能够实现11.73 tokens/秒的Token生成吞吐量。

NVFP4是NVIDIA Blackwell GPU架构引入的4位浮点格式。MXFP4是Open Compute Project (OCP) 制定的微缩FP4 4位浮点格式。

- ISL (Input Sequence Length):输入提示中的Token数量(也称预填充Token)。

- OSL (Output Sequence Length):模型生成的Token数量(也称解码Token)。

NVIDIA DGX Spark凭借其领先的性能、海量内存以及预装的AI软件栈,为AI开发者提供了一个强大、灵活且高效的本地化计算解决方案,显著加速了从模型开发到部署的整个流程。